Stack技術は、イーサネットスイッチポートの拡張により頻繁に使用される非標準化技術です。各メーカー間は混合スタッキングをしておらず、スタッキングモードも各メーカーに独自の標準を開発しています。

Stack技術は、インターネットの大規模なデータセンターネットワークアーキテクチャで一般的な方法として広く使用されています。長年の実践により、Stack技術には高信頼性ネットワークアーキテクチャの場合でメリットとデメリットが両方ともあることがわかりました。サービスの発展とサービス品質要件の改善に伴い、特にパブリッククラウドの場合では、サービスは7×24時間で提供する必要があり、サービスの中断による補償は少なくとも1:100です。したがって、Stack技術のデメリットを解決することが重要になります。

ここでは、Stack技術のメリットとデメリット、「De-stacking」技術提案についてご紹介します。

Stack技術のメリット

管理をシンプル化

ネットワーク内の複数のスイッチをスタッキングにより1台のスイッチにすることで、管理者が管理する必要のある複数のスイッチを1台で管理できるようになります。

管理する必要のポート数は減っていませんが、異なるデバイスに頻繁にログイン操作する時間が短縮され、対応するポート設定も変更されている為、全体的な管理コストが軽減されています。

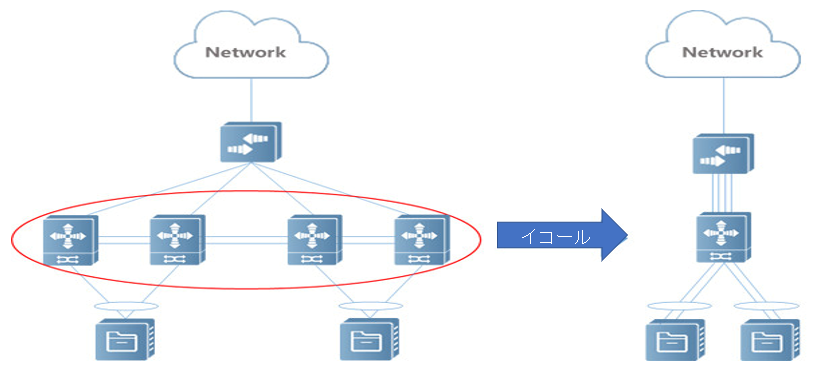

図1に示すように:

▲ 図1

本来、管理者には4つのネットワークデバイスを管理する必要がありましたが、Stack技術によってデバイスをスタッキングした後、管理する必要があるネットワークデバイスは1つになります。

柔軟な拡張

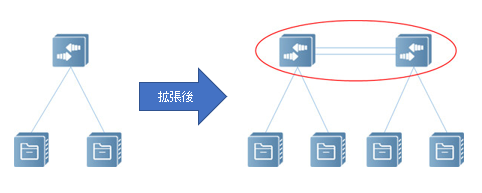

•ポート数の拡大

元のスイッチポートが足りない場合は、新しいスイッチを追加し、Stack技術を利用することで対応できます。

図2に示すように:

▲ 図2

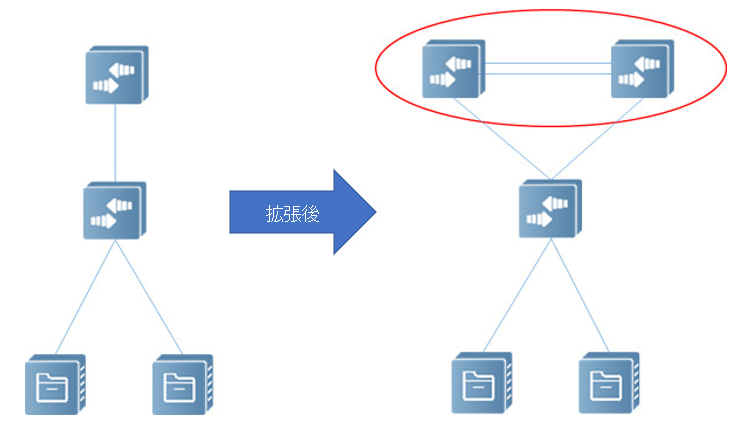

•システム処理能力の拡張

コアスイッチのスループット能力が足りない場合は、新しいスイッチを追加し、Stack技術を利用することで対応できます。

図3に示すように:

▲ 図3

高信頼性

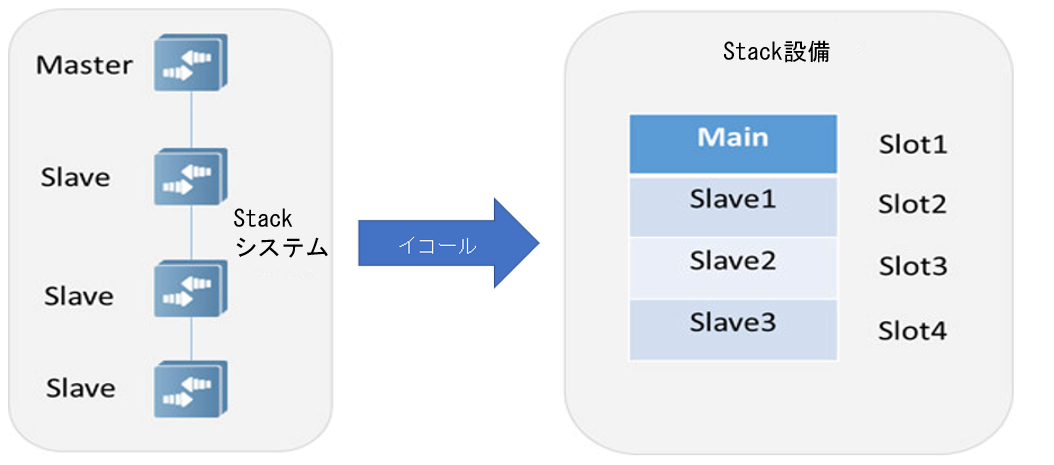

•設備の高信頼性

ボックススイッチでは、1つのCPUとスイッチチップが一般的です。その為、1つのCPUやスイッチチップに問題が発生すると、スイッチ全体が使用できなくなり、リスクが高くなります。Stack技術を使用すれば、フレームスイッチのように、より多くのバックアップコントロールエンジンとラインカードを持つことになります。

図4に示すように:

▲ 図4

Stackシステム内のMasterデバイスは仮想デバイスのメインコントロールエンジンに相当し、Slaveデバイスはバックアップコントロールエンジンに相当します。

•ネットワークの高信頼性

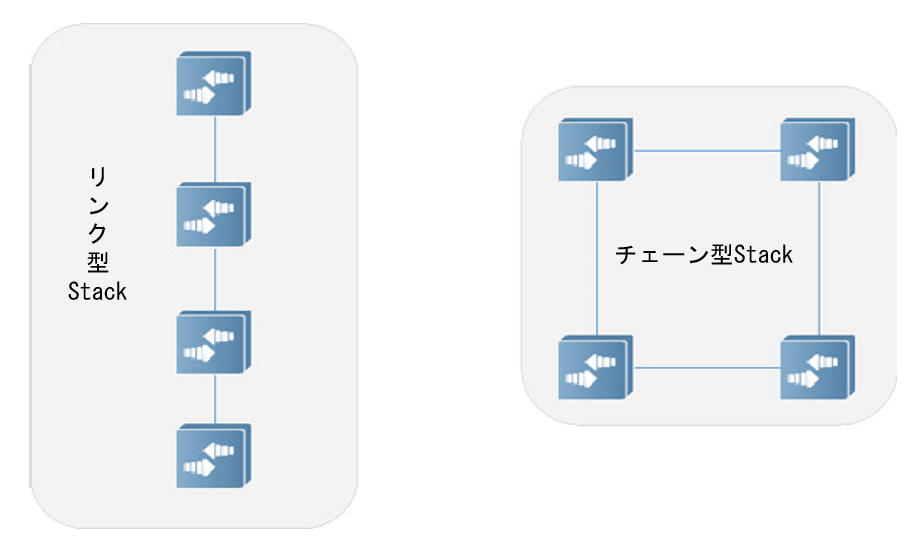

Stackシステムは、チェーン接続とリング接続の2種類の物理トポロジがあります。

図5に示すように:

▲ 図5

チェーン型Stackは、リング型Stackに比べて回線が少なくとも1つ以上節約でき、コスト面にメリットがあります。

リング型のStackは、いずれかの回線が切断されてもStackシステムが壊れることがない為、可用性が高くなります。

Stack技術のデメリット

ソフトウェアのリスク

Stackシステムのソフトウェアバージョンアップの問題は、常にStack技術では回避できない課題であり、どのメーカーの設備を使用しても、ソフトウェアシステムにバグがないことは保証できない為、バグがあればアップグレードして対応します。ISSU(In-service Software Upgrade)のような無中断アップグレードを実現する技術もありますが、ISSUの適用範囲は2つのバージョンの差が小さい状況に限られ、従来のスイッチシステムのアップグレードでは、複数のStackデバイスを同時に再起動する必要があります。その為、サービス中断は回避できません。よって、データセンターの「De-stacking」がトレンドになっています。

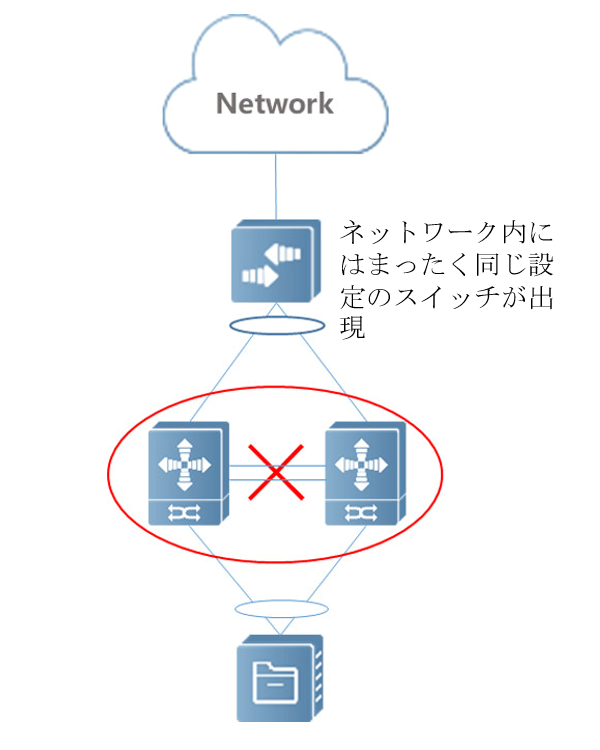

スプリットのリスク

スイッチ間をつなぐ回線に障害や異常がある場合は、Stackシステムがスプリットする可能性があります。一般的ではありませんが、実際のデータセンター中では発生しています。その問題とは、スプリット後、ネットワーク内に全く同じ設定のスイッチが出現してしまい、ネットワーク設定の競合を引き起こすことで、最終的にはStackシステムによってサービス中断を引き起こしてしまうことです。

図6に示すように:

▲ 図6

この問題に対しては解決方法もあります。システムがスプリットを検出すると、Stackポート、管理インターフェイス、管理者が指定した例外ポートを除く全てのポートをシャットダウンし、スプリットがネットワークに影響を与えないようにします。

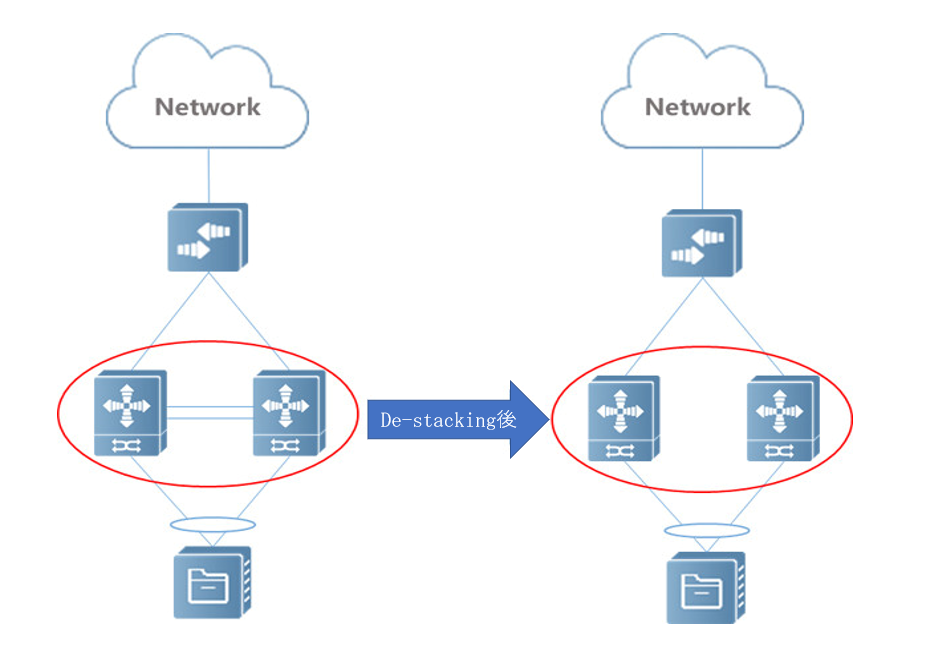

「De-stacking」技術の実現方法

ここで、図 7 に示すように、「De-stacking」の方法――VSU-Liteを紹介します。

▲ 図7

「De-stacking」ネットワーキング機能の実現

サーバーは、デュアルネットワークカード、デュアルアップリンクの接続モードで2つのスイッチを接続し、ネットワークカードモードは:Bond Mode 4、つまりIEEE 802.3ad (LACP、Link Aggregation Control Protocol) プロトコルとなります。

(注: アグリゲーションポートのARP情報は 1つの物理ポートのみに転送される為、「De-stacking」の場合では、両方のスイッチがサーバーからARP要求を受信する必要があります。したがって、サーバーはドライバーを調整する必要がありますがここでは議論しません。)

サーバーはLACPプロトコルを使用している為、プロトコルの正常な動作を保証する為、2つのアクセススイッチが相互接続されていない場合「Spoofing」方法を使用し、アップリンクがまだ1つのデバイスであるとサーバーに「認識」させます。これは、スイッチ設定にいくつかの小さな「再構築」を行う必要があります。

システムIDはシステム優先度とシステムMACで構成されている為、LACPのシステムIDは手動で同じに設定します。

デバイスID(手動設定)をLACPポートID に追加し、サーバーが異なる LACP メンバーポート番号を認識できるようにします。

ゲートウェイのMACアドレスが同じになるように設定します。

ARPプロキシを有効にして、ホストルートを転送し、OSPFやBGPなどのルーティングプロトコルを介してメインネットワークに再配布します。

以上のいくつかの簡単な設定により、サーバーは LACPグループが正常に接続されたと見なします。同時に、ゲートウェイはアクセススイッチとして設定され、データセンターネットワークアーキテクチャの「De-stacking」を実現します。

最適化機能の実現

•ブロードキャスト抑制

スイッチはARPプロキシをオンにすれば、レイヤ 2 転送からレイヤ3転送に変換し、ブロードキャストを抑制できます。

•サイレントサーバーの「アクティベーション」

スイッチはARPスキャン機能を有効にして、サイレントサーバーが外部ネットワークにアクセスできるようにします。

•アップストリームポートの監視

スイッチのアップストリームポートは、監視機能を有効にしてアップストリームトラフィックのパケットロスを回避する為、すべてのアップストリームポートが中断された後、ダウンストリームポートが閉じられます。ポートの発振によるネットワークの頻繁な変更を防止するために、ダウンストリームポートを遅延オープンに設定することもできます。

まとめ

以上は、データセンターネットワークアーキテクチャにおける「De-stacking」の方法です。Ruijie Networks Japan株式会社のデータセンタースイッチ製品は、VSU-Lite技術による「De-stacking」の実現を完全にサポートしています。「De-stacking」に興味ある場合は、ぜひお気軽にご相談ください。